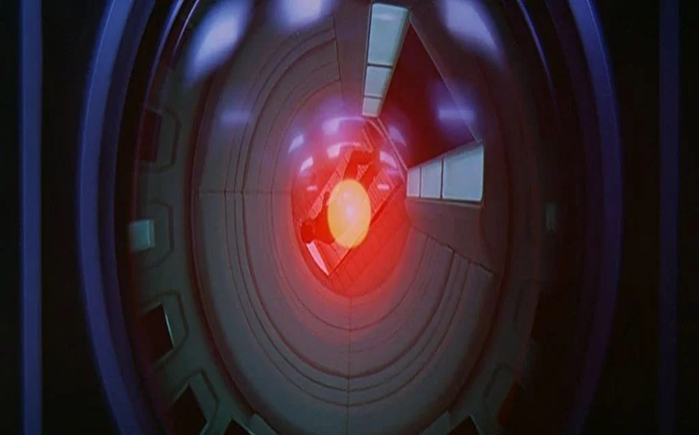

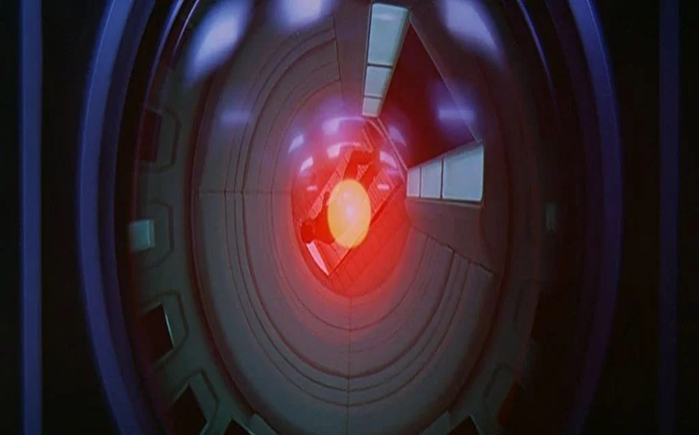

انتشر الحديث عن روبوتات الذكاء الاصطناعي وقدرتها على الإطاحة بالجنس البشري لعقود عديدة. في يناير 2021 أصدر العلماء بحثًا جديدًا حول إن كنا قادرين على التحكم بالحواسيب فائقة الذكاء، وإجابتهم كانت مرعبة: بالكاد سنستطيع التحكم بها.

المعضلة أن التحكم في كيانات فائقة الذكاء لدرجة تتجاوز بكثير الإدراك البشري يتطلب وجود محاكاة لها حتى نتمكن من تحليلها. لكن إذا كنا غير قادرين على فهمها، فيستحيل علينا إنشاء مثل هذه المحاكاة.

يقترح المشاركون في بحث 2021 أننا سنفشل في وضع قواعد تحمي البشر من أي ضرر قد يلحق بهم على يد الروبوتات ما لم نفهم طبيعة السيناريوهات التي سينتجها الذكاء الاصطناعي. فبمجرد أن يعمل أي نظام حاسوبي على مستوى أعلى من إدراك المبرمجين تخرج الأمور عن نطاق سيطرتنا.

كتب الباحثون: «إن الذكاء الفائق يطرح مشكلةً مختلفةً اختلافًا جوهريًا عما يُعرف بـأخلاقيات الروبوت، فهو لأن الذكاء الفائق متعدد الأوجه، وعليه يُحتمل أن يكون قادرًا على استغلال مجموعة متنوعة من الموارد من أجل تحقيق أهداف يُحتمل أن تكون غير مفهومة أو قابلة للتحكم من قبل البشر».

يعتمد الفريق جزئيًا في استدلاله على مسألة التوقف في نظرية الحاسوبية التي طرحها آلان تورينج في عام 1936. وتتمحور المسألة على معرفة إن كان برنامج الكمبيوتر سيصل إلى نتيجة ما ويتوقف، أم أنه سيفشل في الوصول إلى نتيجة ويستمر في بحثه إلى أن يشكل حلقة مفرغة من التعقيد.

أثبت تورينج عبر بعض الرياضيات الذكية أنه رغم قدرتنا على معرفة إن كانت بعض البرامج ستتوقف ومتى، يستحيل معرفة ذلك مع كل البرامج في أي وقت، وهذا يُرجعنا إلى الروبوتات الاصطناعية خارقة الذكاء التي يمكنها عمليًا الاحتفاظ بكل برامج الكمبيوتر في ذاكرتها في وقت واحد.

أي برنامج كُتب لمنع الذكاء الاصطناعي من إلحاق الأذى بالبشر وتدمير العالم، على سبيل المثال، قد يصل إلى نتيجة ويتوقف أو يستمر – من المستحيل رياضيًا أن نتأكد تمامًا من الحالتين، ما يعني أنه غير قابل للاحتواء.

قال عالم الكمبيوتر إياد رهوان، من معهد ماكس بلانك للتنمية البشرية في ألمانيا: «في الواقع، هذا يجعل خوارزمية الاحتواء غير قابلة للاستخدام».

يقول الباحثون إن البديل لتعليم كيانات الذكاء الاصطناعي بعض الأخلاقيات وإخبارها بعدم تدمير العالم -وهو أمر لا يمكن لأي خوارزمية أن تكون متأكدة تمامًا من القيام به- هو الحد من قدراتها الفائقة، مثل تقليص مدى استغلالها لشبكة الإنترنت أو شبكات معينة.

ترفض الدراسة الحديثة فكرة الحد من قدرات الذكاء الاصطناعي لأن ذلك سينافي الغرض الذي طُوّر من أجله. يتساءل المعارضون: إذا لم نستخدم الذكاء الاصطناعي لحل مشكلات خارج نطاق فهم البشر، فما الغاية من إنشائه أصلًا؟

تطوير مجال الذكاء الاصطناعي ربما سيؤدي بنا عن غير قصد إلى إنشاء كيانات خارقة وخارجة عن سيطرتنا، وهو ما يستدعي البدء في طرح بعض الأسئلة الجادة حول هذا المجال والاتجاهات التي نسير فيها.

قال عالم الكمبيوتر مانويل سيبريان، من معهد ماكس بلانك للتنمية البشرية: «تبدو فكرة الآلات فائقة الذكاء التي تتحكم في العالم مثل الخيال العلمي، ولكن توجد بالفعل آلات تؤدي مهام مهمة معينة بصورة مستقلة دون أن يفهم المبرمجون تمامًا كيفية تعلمها هذه المهام».

يتساءل مانويل: «السؤال الذي يطرح نفسه: هل ستخرج كيانات الذكاء الاصطناعي عن نطاق السيطرة في مرحلة ما وتشكل خطرًا يهدد الجنس البشري؟».

المصدر:ibelieveinsci

المعضلة أن التحكم في كيانات فائقة الذكاء لدرجة تتجاوز بكثير الإدراك البشري يتطلب وجود محاكاة لها حتى نتمكن من تحليلها. لكن إذا كنا غير قادرين على فهمها، فيستحيل علينا إنشاء مثل هذه المحاكاة.

يقترح المشاركون في بحث 2021 أننا سنفشل في وضع قواعد تحمي البشر من أي ضرر قد يلحق بهم على يد الروبوتات ما لم نفهم طبيعة السيناريوهات التي سينتجها الذكاء الاصطناعي. فبمجرد أن يعمل أي نظام حاسوبي على مستوى أعلى من إدراك المبرمجين تخرج الأمور عن نطاق سيطرتنا.

كتب الباحثون: «إن الذكاء الفائق يطرح مشكلةً مختلفةً اختلافًا جوهريًا عما يُعرف بـأخلاقيات الروبوت، فهو لأن الذكاء الفائق متعدد الأوجه، وعليه يُحتمل أن يكون قادرًا على استغلال مجموعة متنوعة من الموارد من أجل تحقيق أهداف يُحتمل أن تكون غير مفهومة أو قابلة للتحكم من قبل البشر».

يعتمد الفريق جزئيًا في استدلاله على مسألة التوقف في نظرية الحاسوبية التي طرحها آلان تورينج في عام 1936. وتتمحور المسألة على معرفة إن كان برنامج الكمبيوتر سيصل إلى نتيجة ما ويتوقف، أم أنه سيفشل في الوصول إلى نتيجة ويستمر في بحثه إلى أن يشكل حلقة مفرغة من التعقيد.

أثبت تورينج عبر بعض الرياضيات الذكية أنه رغم قدرتنا على معرفة إن كانت بعض البرامج ستتوقف ومتى، يستحيل معرفة ذلك مع كل البرامج في أي وقت، وهذا يُرجعنا إلى الروبوتات الاصطناعية خارقة الذكاء التي يمكنها عمليًا الاحتفاظ بكل برامج الكمبيوتر في ذاكرتها في وقت واحد.

أي برنامج كُتب لمنع الذكاء الاصطناعي من إلحاق الأذى بالبشر وتدمير العالم، على سبيل المثال، قد يصل إلى نتيجة ويتوقف أو يستمر – من المستحيل رياضيًا أن نتأكد تمامًا من الحالتين، ما يعني أنه غير قابل للاحتواء.

قال عالم الكمبيوتر إياد رهوان، من معهد ماكس بلانك للتنمية البشرية في ألمانيا: «في الواقع، هذا يجعل خوارزمية الاحتواء غير قابلة للاستخدام».

يقول الباحثون إن البديل لتعليم كيانات الذكاء الاصطناعي بعض الأخلاقيات وإخبارها بعدم تدمير العالم -وهو أمر لا يمكن لأي خوارزمية أن تكون متأكدة تمامًا من القيام به- هو الحد من قدراتها الفائقة، مثل تقليص مدى استغلالها لشبكة الإنترنت أو شبكات معينة.

ترفض الدراسة الحديثة فكرة الحد من قدرات الذكاء الاصطناعي لأن ذلك سينافي الغرض الذي طُوّر من أجله. يتساءل المعارضون: إذا لم نستخدم الذكاء الاصطناعي لحل مشكلات خارج نطاق فهم البشر، فما الغاية من إنشائه أصلًا؟

تطوير مجال الذكاء الاصطناعي ربما سيؤدي بنا عن غير قصد إلى إنشاء كيانات خارقة وخارجة عن سيطرتنا، وهو ما يستدعي البدء في طرح بعض الأسئلة الجادة حول هذا المجال والاتجاهات التي نسير فيها.

قال عالم الكمبيوتر مانويل سيبريان، من معهد ماكس بلانك للتنمية البشرية: «تبدو فكرة الآلات فائقة الذكاء التي تتحكم في العالم مثل الخيال العلمي، ولكن توجد بالفعل آلات تؤدي مهام مهمة معينة بصورة مستقلة دون أن يفهم المبرمجون تمامًا كيفية تعلمها هذه المهام».

يتساءل مانويل: «السؤال الذي يطرح نفسه: هل ستخرج كيانات الذكاء الاصطناعي عن نطاق السيطرة في مرحلة ما وتشكل خطرًا يهدد الجنس البشري؟».

المصدر:ibelieveinsci